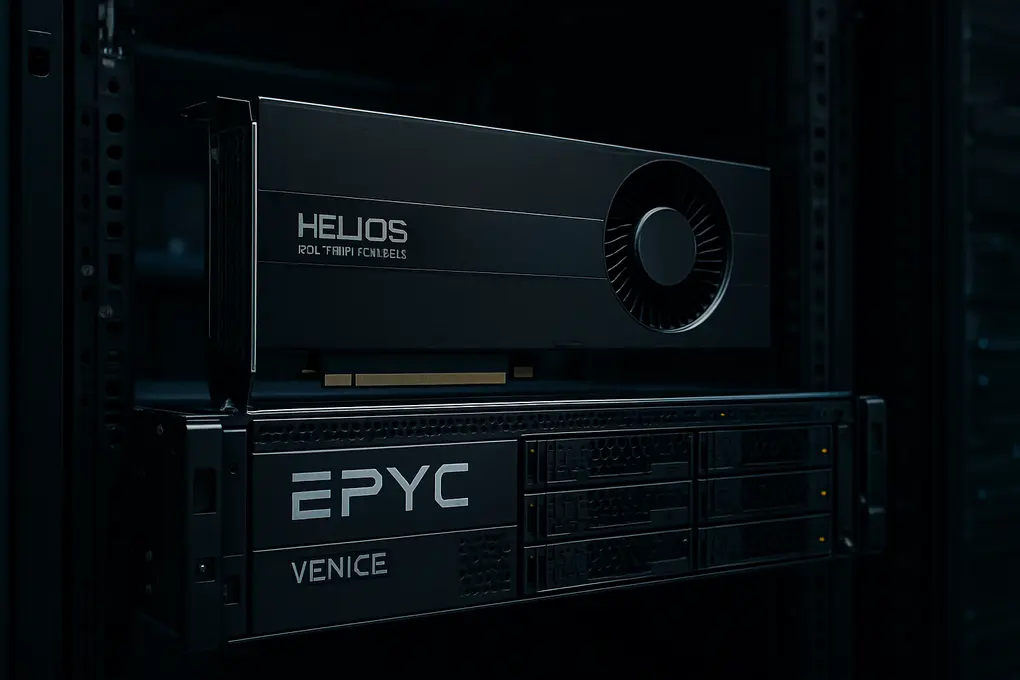

Helios con Instinct MI455X y Epyc Venice: AMD entra en la guerra de racks de IA

Helios con Instinct MI455X es la apuesta más agresiva de AMD para el datacenter de IA: un sistema rack-scale que combina GPUs Instinct MI455X (familia MI400) con CPUs Epyc Venice (Zen 6), una arquitectura de interconexión basada en Ethernet y una nueva capa de networking de su división Pensando. El objetivo es claro: competir en el mismo terreno que los racks NVL72 de Nvidia, donde el rendimiento ya no depende solo de FLOPS, sino de memoria HBM, ancho de banda chip-to-chip y escala de red.

Helios con Instinct MI455X: lo que AMD ha confirmado

AMD mostró públicamente el empaquetado de la Instinct MI455X y parte de la composición del rack Helios. Según la información presentada, Helios integrará 72 GPUs MI455X y organizará los nodos con una CPU Epyc Venice por cada cuatro GPUs. AMD también posiciona Helios como un diseño orientado a despliegues a gran escala, citando el interés esperado de grandes actores de IA.

A nivel de acelerador, AMD atribuye a cada MI455X cifras de rendimiento orientadas a IA: alrededor de 40 petaFLOPS en FP4 (inference) o 20 petaFLOPS en FP8 (training), además de 432 GB de HBM4 con 19,6 TB/s de ancho de banda y 3,6 TB/s para comunicaciones chip-to-chip.

En agregado, AMD afirma que el rack Helios (72 GPUs) apunta a 2,9 exaFLOPS en FP4 denso, 1,4 exaFLOPS en FP8, 31 TB de HBM4 y 1,4 PB/s de ancho de banda de memoria, situándolo en el rango de las configuraciones rack-scale más avanzadas del mercado.

MI400: tres variantes para hyperscale, enterprise y HPC

Dentro de la familia Instinct MI400, AMD desglosó al menos tres variantes con enfoques diferentes:

-

Instinct MI455X: GPU optimizada para IA, destinada a alimentar Helios.

-

Instinct MI440X: opción orientada a configuraciones más convencionales tipo caja de 8 GPUs (enterprise), en la línea de plataformas que AMD ya utiliza en MI355X y MI325X.

-

Instinct MI430X: enfoque mixto HPC + IA, con intención de equilibrar FP64/FP32 para cómputo científico y FP8/FP4 para cargas de IA.

La promesa “1000x” y por qué importa el contexto

AMD también adelantó la generación MI500 (prevista para 2027) con una afirmación de “1.000x” de mejora frente a MI300X. Sin embargo, la propia compañía matizó que la comparación se basa en un nodo de ocho MI300X frente a un sistema rack MI500 con un número de GPUs no especificado, por lo que no se trata de un benchmark equivalente. En infraestructuras de IA, la métrica efectiva depende tanto de la red, la latencia y el software de distribución como de la capacidad de cómputo y el ancho de banda de memoria.

Aun con esa cautela, la dirección estratégica es consistente: la competencia real se está desplazando a sistemas rack-scale donde el rendimiento se expresa como plataforma (GPU + CPU + memoria + interconexión + switching) y no como un único chip.

Epyc Venice: hasta 256 núcleos Zen 6 y más I/O

En CPU, AMD enseñó un vistazo detallado a Epyc Venice, que será su CPU de datacenter de mayor recuento de núcleos hasta la fecha. La compañía confirmó que Venice llegará hasta 256 núcleos Zen 6 y señaló un aumento de ancho de banda tanto de memoria como hacia GPU frente a la generación anterior. En el análisis del silicio mostrado, el diseño aparenta usar ocho chiplets de 32 núcleos y dos dies de I/O, lo que encaja con el objetivo de densidad extrema para datacenter.

AMD no detalló públicamente la configuración final de canales de memoria ni el conteo exacto de líneas PCIe, pero sí dejó claro que Venice está pensado para alimentar plataformas con un número elevado de aceleradores, como Helios.

“X” para HPC: más caché 3D en el roadmap

AMD también reiteró que mantendrá variantes “X” orientadas a HPC, históricamente asociadas a 3D V-Cache para elevar masivamente la L3. Este enfoque busca sostener competitividad en workloads científicos además de IA, un punto relevante para centros que combinan training, inference y simulación.

Networking en Helios: 800GbE, DPU y UALink sobre Ethernet

Uno de los elementos más importantes en Helios con Instinct MI455X es la red. AMD indicó que el rack integrará hasta doce NICs “Volcano” de 800 Gbps (tres por GPU) para construir el tejido de escala (scale-out fabric) que conecta nodos y racks. Además, el diseño incorpora una DPU de Pensando (Solina) para descargar tareas como software-defined networking, almacenamiento y seguridad, liberando CPU y GPU para cargas de IA.

Para unir las 72 GPUs como un acelerador lógico a nivel de rack, AMD utilizará Ultra Accelerator Link (UALink), una alternativa abierta a NVLink, pero en este caso tunelada sobre Ethernet. En implementaciones de partners, el switching puede recaer en ASICs como Broadcom Tomahawk 6, según se explicó en el contexto de despliegues previstos.

Qué significa para el mercado de IA en datacenter

Helios con Instinct MI455X marca el giro de AMD hacia el modelo de plataforma completa para IA, en el que el valor se concentra en rack designs, memoria HBM4, interconexión y escalabilidad. En paralelo, la existencia de MI440X en configuraciones de 8 GPUs sugiere que AMD no abandona el formato enterprise clásico, relevante para organizaciones que no pueden operar racks completos o dependen de despliegues on-prem por coste, control o cumplimiento.

El reto para AMD no será solo igualar cifras de cómputo, sino demostrar rendimiento efectivo en modelos reales (training e inference) y madurez de software y ecosistema. La compañía anticipa más detalles conforme se acerque el lanzamiento de Venice y de la serie MI400, previsto para la segunda mitad de 2026.

Para información oficial adicional, AMD centraliza anuncios y hojas de ruta en su newsroom (https://www.amd.com/en/newsroom) y especificaciones de productos en su portal Instinct (https://www.amd.com/en/products/accelerators/instinct.html). Sobre el estándar de interconexión mencionado, puede consultarse la iniciativa UALink en su sitio oficial (https://ualinkconsortium.org/). Helios con Instinct MI455X será, en ese contexto, una de las primeras vitrinas para medir si el enfoque abierto de interconexión sobre Ethernet puede sostenerse frente a las arquitecturas propietarias en la era del rack-scale AI.